Ollama docker 安装部署

1.安装Ollama

备注:我的开发服务器没有显卡,所以只能用 CPU 来跑。

如果您的机器支持 GPU,可添加 GPU 参数支持,参考:https://hub.docker.com/r/ollama/ollama

1.1方式一:编辑 docker-compose.yml 文件

version: '3'

services:

ollama:

image: ollama/ollama

container_name: ollama

ports:

- "11434:11434"

volumes:

- /docker-volumes/ollama:/root/.ollama

# restart: always

然后输入命令 docker compose up -d 或者 docker-compose up -d 运行

1.2方式二:docker 命令

sudo docker pull ollama/ollama

sudo docker run -d -p 11434:11434 -v /docker-volumes/ollama:/root/.ollama --name ollama ollama/ollama

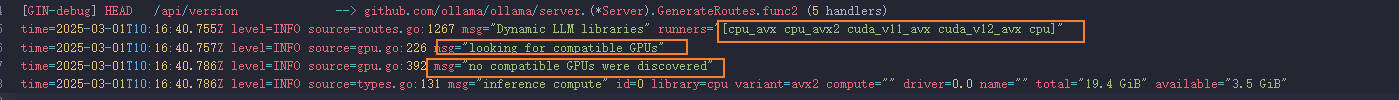

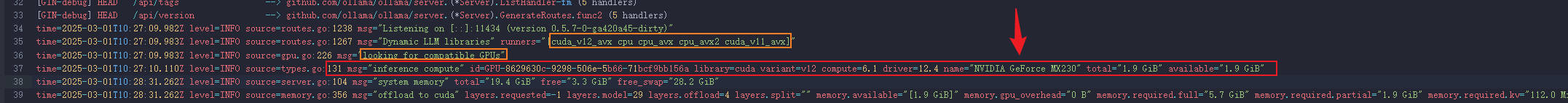

注意日志输出

如果是 CPU 运行日志会输出以下日志

如果是 GPU 运行日志会输出以下日志并显示 GPU 型号

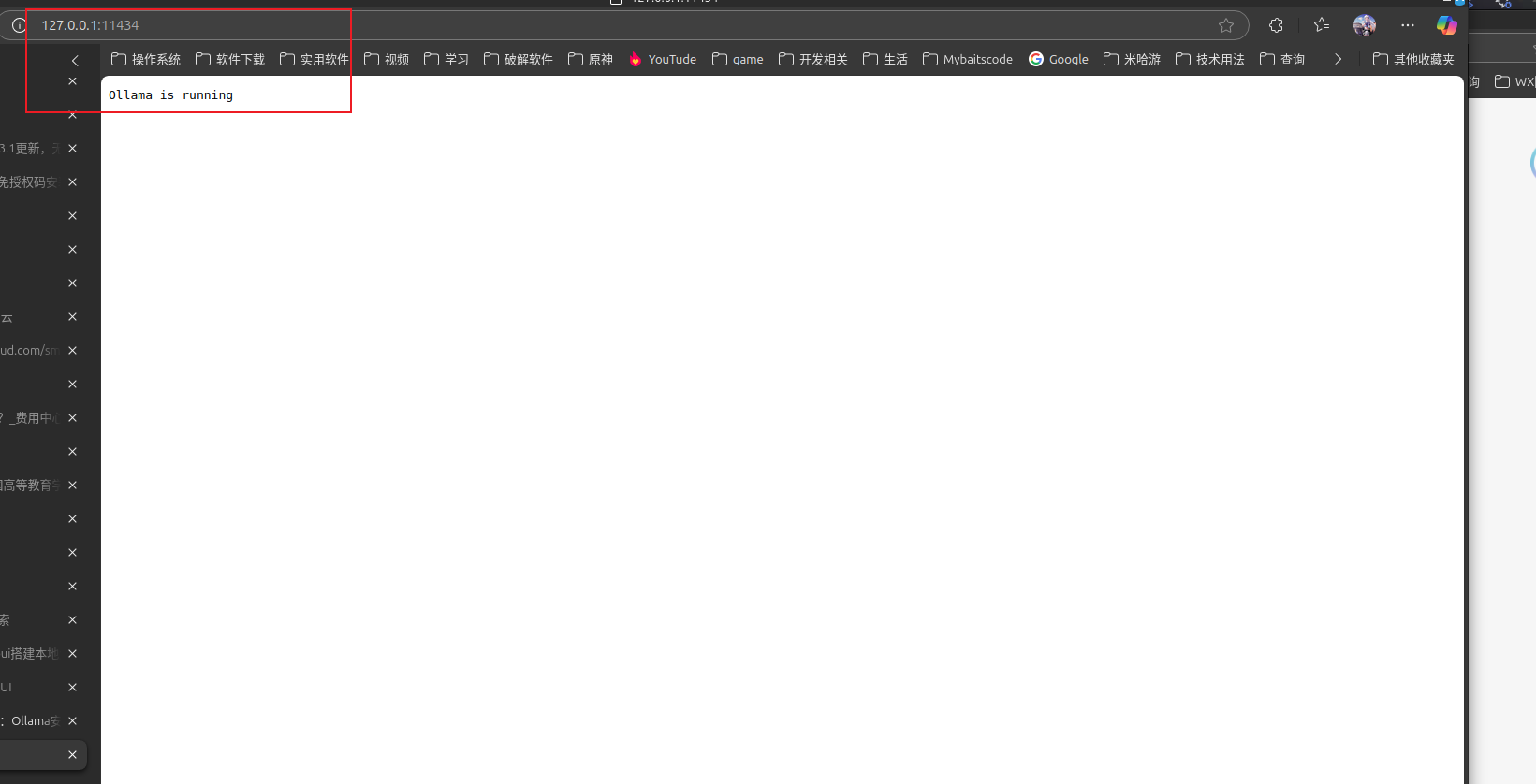

1.3 测试一下

访问:http://IP:11434,看到提示 Ollama is running 就说明成功了,如下图:

2.使用Ollama部署大模型

Ollama 安装完毕后,还需要继续下载大模型,支持的大模型可以在 Ollama 官网找到:https://ollama.com/library。Ollama 默认没有提供 WEB 界面,需要通过命令行来使用,先输入命令进入容器:

docker exec -it ollama /bin/bash

进入容器后,去上面官网找到你想要下载的大模型,比如我们下载一个deepseek-r1的模型,命令如下:

ollama run deepseek-r1

3.Web-Ui

ollama-chat-ui-vue 点击前往

使用vue3 + vite + elementUi 搭建的前端 chat, 通过 ollama 可与模型对话, 目前已经支持deepseek的独立思考标签和切换模型 (联网查询后续支持)